Introducción a la Optimización por PROmpting

En un mundo cada vez más digitalizado, la optimización de algoritmos y procesos es una tarea esencial. Sin embargo, los optimizadores derivados a menudo encuentran dificultades en aplicaciones del mundo real. En respuesta a este desafío, DeepMind ha propuesto una nueva técnica: la Optimización por PROmpting (OPRO). Esta se basa en el uso de Modelos de Lenguaje Grande (LLM) como optimizadores. En lugar de definir el problema de optimización en términos matemáticos o algorítmicos, se describe en lenguaje natural. Esto permite que el método sea adaptable y flexible, ya que se puede modificar la descripción del problema o añadir instrucciones específicas para guiar el proceso de optimización.

Funcionamiento y ventajas de OPRO

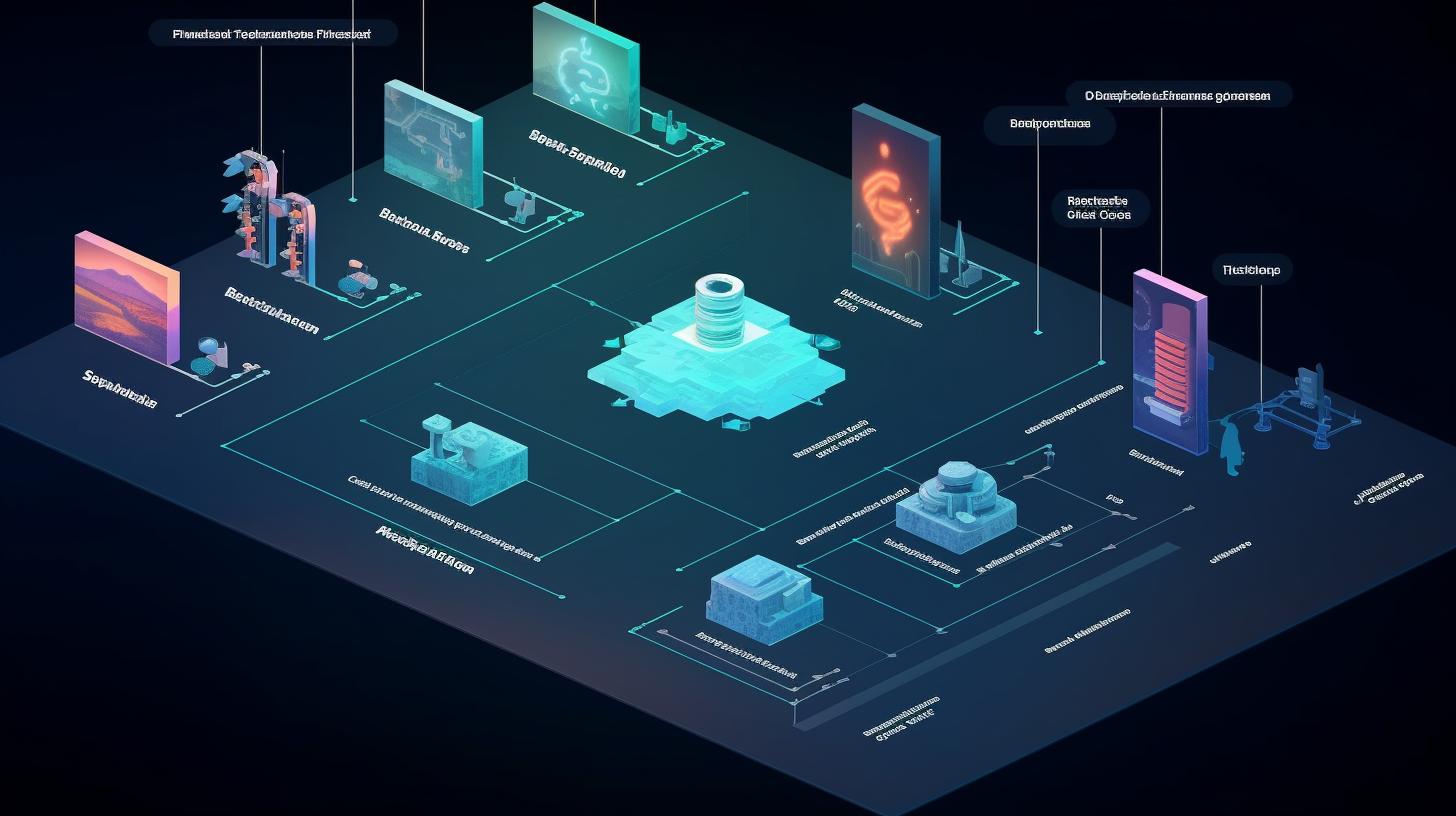

El funcionamiento de OPRO comienza con un «meta-prompt» que incluye una descripción del problema, ejemplos, instrucciones y soluciones previas. A partir de esta información, el LLM genera soluciones candidatas basadas en la descripción del problema y las soluciones previas. Estas soluciones son evaluadas y puntuadas, añadiendo las óptimas al meta-prompt para enriquecer el contexto y mejorar las futuras iteraciones.

Las ventajas de OPRO son notables. La capacidad de los LLM para entender el lenguaje natural permite describir tareas sin necesidad de especificaciones formales. Además, se pueden especificar métricas objetivo e instrucciones adicionales para guiar la optimización. Por último, los LLM tienen la capacidad para detectar patrones en el contexto, lo que les permite identificar una trayectoria de optimización basada en los ejemplos proporcionados.

Validación y potencial de OPRO

Para validar OPRO, DeepMind realizó pruebas en dos problemas matemáticos conocidos: la regresión lineal y el «problema del vendedor viajero». Aunque los resultados obtenidos no son la forma más óptima de resolver estos problemas, son prometedores y demuestran el potencial de la técnica.

Además, OPRO tiene un gran potencial para optimizar los prompts de los LLM. La salida de un modelo depende en gran medida de la ingeniería del prompt, y OPRO puede ayudar a optimizar este proceso para modelos como OpenAI’s ChatGPT y Google’s PaLM.

Un ejemplo de uso de OPRO es la tarea de encontrar el prompt óptimo para resolver problemas matemáticos en palabras. A través de la generación y evaluación de diferentes prompts de optimización, se puede mejorar iterativamente el rendimiento hasta llegar a la convergencia.

En pruebas realizadas con varios LLMs de las familias PaLM y GPT, se obtuvieron resultados intrigantes que demuestran diferencias en el comportamiento del LLM dependiendo del prompt. Esto subraya la importancia de una buena ingeniería del prompt y el potencial de OPRO para mejorarla.

Conclusión

Aunque debemos evitar la antropomorfización de los LLMs, las ventajas claras de OPRO son evidentes. Esta técnica permite una exploración sistemática del espacio de posibles prompts de LLM. Aunque todavía hay incertidumbre sobre cómo se mantendrá en aplicaciones del mundo real, tiene un gran potencial para avanzar en nuestra comprensión de cómo funcionan los LLMs.

Clara es creadora y editora de contenidos, con una sólida formación en ciencias y una especialización en inteligencia artificial. Su pasión por este campo en constante evolución la ha llevado a adquirir los conocimientos necesarios para comprender y comunicar los avances más recientes en este campo. Con su experiencia y habilidades en la redacción y edición de contenidos, Clara es capaz de transmitir de manera clara y efectiva conceptos complejos relacionados con la inteligencia artificial y de esta manera hacerlos accesibles para todo tipo de audiencias.