L’importance croissante des Unités de Traitement Neuronal à l’ère de l’Intelligence Artificielle

À l’ère actuelle de l’Intelligence Artificielle (IA), les Unités de Traitement Neuronal (NPU) gagnent en importance. Des géants de l’industrie des puces comme Qualcomm, Intel, AMD, Apple, Samsung et Huawei investissent dans le développement de puces avec NPU pour améliorer l’efficacité et les performances de leurs appareils.

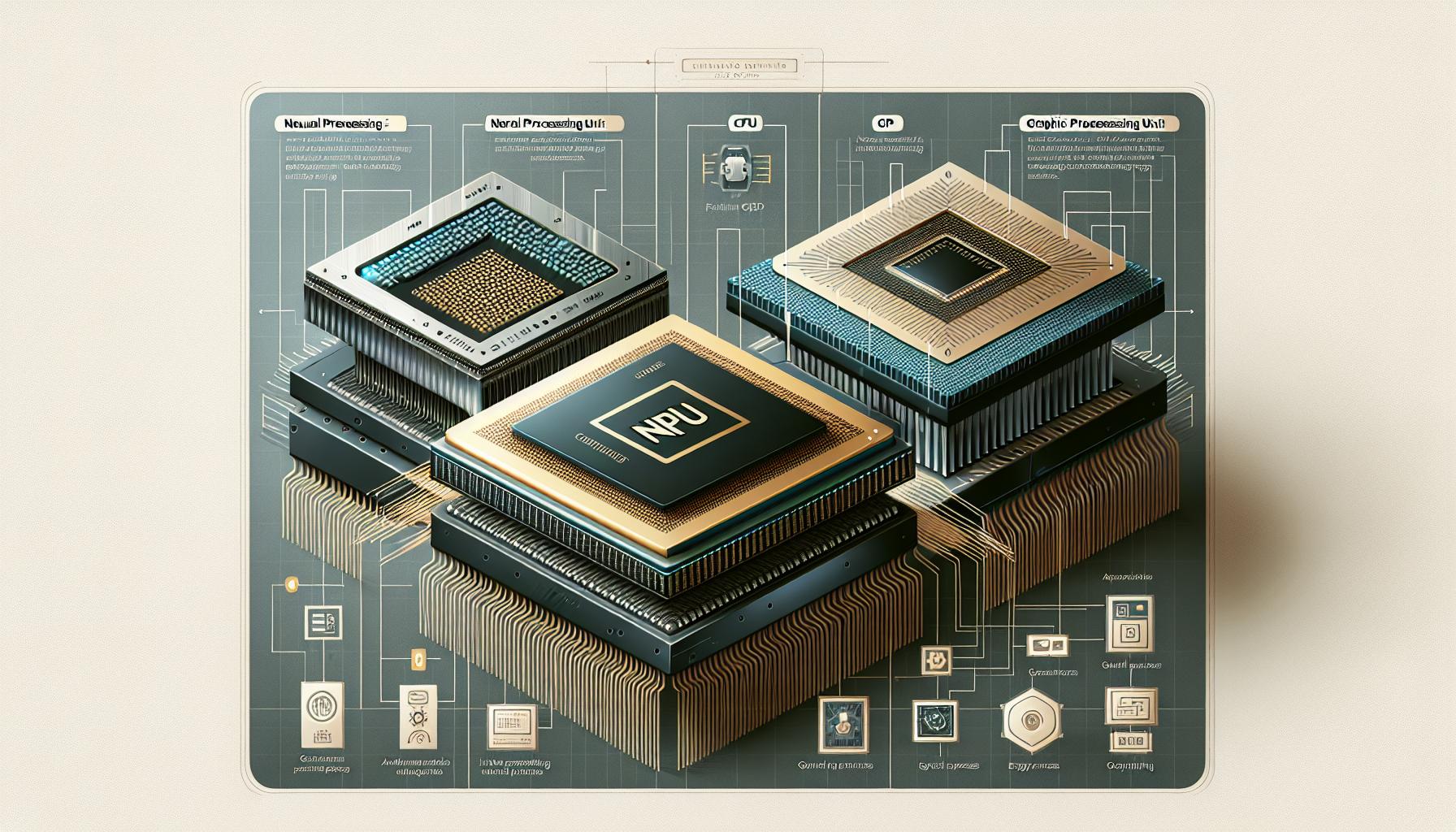

La Calcul Hétérogène et le rôle des NPU

Le calcul hétérogène est un concept qui fait référence à l’utilisation de différents types de processeurs ou de cœurs dans un seul système, dans le but de maximiser les performances et l’efficacité énergétique. Les composants principaux de ce type de calcul sont le CPU, qui est utilisé pour des tâches générales ; le GPU, qui gère les processus graphiques ; et le NPU, qui est utilisé pour les processus d’IA. Bien qu’il soit possible d’exécuter des processus d’IA sur n’importe quelle unité de traitement, le faire sur une unité non spécifiquement conçue pour cela peut avoir des conséquences en termes de performances et d’efficacité énergétique.

En ce qui concerne l’IA, le GPU est la meilleure option pour la parallélisation massive, offrant une haute performance, mais il est moins efficace en termes d’énergie. Le CPU peut exécuter des processus d’IA, mais avec une performance et une consommation inférieures à celles du GPU. D’autre part, le NPU, spécifiquement conçu pour les processus d’IA, est plus efficace en termes d’énergie, bien qu’il puisse offrir une performance inférieure dans les processus plus exigeants.

L’intégration des NPU dans les puces Intel et AMD

Des entreprises comme Intel et AMD intègrent déjà des NPU dans leurs puces, et on s’attend à ce que cette stratégie s’étende à d’autres lignes de produits à l’avenir. Quelques exemples de cette tendance sont les processeurs Intel Core Ultra avec microarchitecture Meteor Lake et les Ryzen 7040 et 8040 d’AMD avec architecture XDNA, qui intègrent des NPU pour améliorer la performance dans les tâches d’IA.

En conclusion, la coexistence et la compréhension entre le CPU, le GPU et le NPU sont essentielles pour maximiser la performance et l’efficacité énergétique à l’ère de l’IA. Cette tendance bénéficie non seulement aux entreprises qui produisent ces puces, mais aussi aux utilisateurs, qui peuvent profiter d’appareils plus puissants et efficaces.

Clara est créatrice et éditrice de contenus, avec une solide formation en sciences et une spécialisation en intelligence artificielle. Sa passion pour ce domaine en constante évolution l'a amenée à acquérir les connaissances nécessaires pour comprendre et communiquer les avancées les plus récentes dans ce domaine. Grâce à son expérience et à ses compétences en rédaction et édition de contenus, Clara est capable de transmettre de manière claire et efficace des concepts complexes liés à l'intelligence artificielle et ainsi les rendre accessibles à tous types de publics.

Cette entrée est également disponible dans : Español Português